Proxy-Server – unverzichtbares Werkzeug für Web-Scraping

Warum Proxies für Scraping benötigt werden

Web-Scraping, also das Extrahieren von Daten aus öffentlich zugänglichen Internetquellen, wird immer gefragter. Unternehmen nutzen Scraping aktiv für die automatisierte Sammlung von Konkurrenzpreisen, Kundenbewertungen, Nachfrageindikatoren für Produkte und vieles mehr.

Allerdings birgt intensives Scraping Tücken. Viele Websites beschränken die Anzahl der Anfragen pro IP-Adresse, um eine Überlastung ihrer Server zu verhindern. Nach Überschreiten der Limits wird die IP gesperrt, was eine weitere Datenerfassung unmöglich macht.

Zur Lösung dieses Problems werden Proxy-Server aktiv eingesetzt. Indem Scraper-Anfragen über Hunderte und Tausende von IP-Adressen aus einem Proxy-Pool verteilt werden, lassen sich Sperren effektiv vermeiden und Daten in industriellem Maßstab sammeln.

Wie genau werden Proxys für Web Scraping eingesetzt?

Es gibt mehrere Hauptbereiche, in denen Proxy-Server unverzichtbar sind, um Web-Scraping-Aufgaben zu lösen:

Analytik für Marktplätze und Handelsplattformen

Dienste wie Amalytix, Amalyze und Helium10 bieten detaillierte Analysedaten für Verkäufer auf großen Online-Plattformen wie Amazon – Statistiken zu Wettbewerbern, Preis- und Verkaufsdynamiken, Bewertungen und Käuferrezensionen für jede Produktgruppe. Diese Daten sind von entscheidender Bedeutung für den Aufbau einer erfolgreichen Verkaufsstrategie und -taktik.

Allerdings veröffentlichen die Marktplätze selbst keine so detaillierten Statistiken. Um sie zu sammeln, müssen Dutzende und Hunderttausende von Anfragen pro Minute an die API gesendet und die Serverantworten geparst werden. Mit einem Computer oder sogar Hunderten von Geräten ist dies nicht möglich – die Skalierung wird bald auf die Einschränkungen der Handelsplattform für die Anzahl der Anfragen pro IP stoßen.

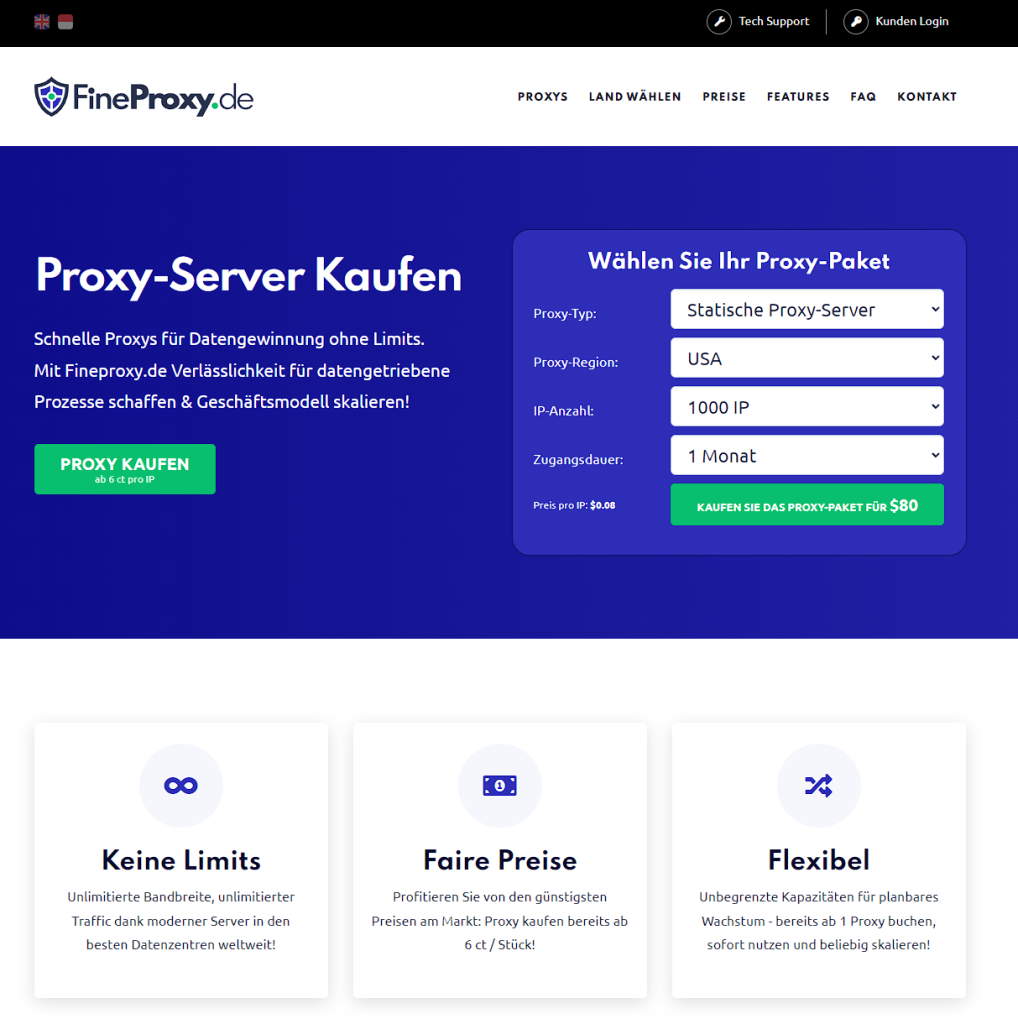

Aus diesem Grund nutzen solche Analysedienste umfangreiche Proxy-Server-Pools von Drittanbietern. Unser Unternehmen Fineproxy stellt eine Infrastruktur mit über 100.000 IP-Adressen bereit. Indem Scraper-Anfragen über unsere Proxies verteilt werden, umgehen Kunden problemlos Sperren und sammeln effizient die benötigten großen Datenmengen von Marktplätzen und Handelsplattformen.

Analytik für die Gastgewerbeindustrie

Unternehmen wie RateGain und SiteMinder bieten speziell für den Tourismus- und Gastgewerbesektor Analysedienste an. Mithilfe von Scraping sammeln sie für ihre Hotelkunden Preise und Verfügbarkeiten bei der Konkurrenz, Kundenbewertungen, Nachfrageindikatoren für verschiedene Reiseziele – aus Quellen wie Booking.com, AirBnb, Agoda, TripAdvisor.

Diese Daten ermöglichen es Hotels beispielsweise, ihre Preise dynamisch anzupassen, um wettbewerbsfähig zu bleiben. Oder ihre Schwachstellen beim Service zu erkennen, indem sie negative Bewertungen analysieren.

Ebenso beschränken beliebte Buchungsseiten für Unterkünfte die Anzahl der Anfragen pro IP. Daher müssen Tourismus-Analyseplattformen auf die Dienste von Proxy-Anbietern wie Fineproxy.de zurückgreifen. Nur durch die Verteilung der Last auf Hunderte von IP-Adressen aus unserem Pool können sie umfangreiche Datenmengen effizient extrahieren und analysieren.

Universelle Web-Scraper

Neben spezialisierten Lösungen gibt es auch universelle Plattformen für das Web-Scraping. Wie ParseHub, ScraperAPI und Octoparse.

Sie ermöglichen das Erstellen eigener Scripte zum Sammeln von Daten von beliebigen Websites ohne Programmierkenntnisse. Es reicht aus, die gewünschten Seiten, zu extrahierenden Daten anzugeben und den fertigen Scraper auszuführen.

Solche Tools sind für die Automatisierung von Geschäftsprozessen, persönlichen Forschungsprojekten und routinemäßigen Aufgaben gefragt. Abhängig vom Scraping-Umfang können sie ebenfalls zusätzliche Proxies benötigen, um Sperren zu vermeiden.

Ich hoffe, die deutsche Übersetzung ist hilfreich. Bitte lassen Sie mich wissen, wenn Sie Unterstützung beim Übersetzen des restlichen Textes benötigen!

Fazit

Die Verwendung von Proxy-Servern ist obligatorisch für jedes Tool, das umfangreiches Scraping von Web-Daten betreibt. Egal ob spezialisierte Lösungen für Online-Handel und Tourismus oder universelle Plattformen.

Nur durch die Verteilung von Skript-Anfragen auf einen riesigen Proxy-Pool mit externen IP-Adressen lassen sich Sperrungen der Zielwebsites zuverlässig vermeiden. Somit kann der Prozess der Sammlung und Analyse großer Datenmengen effektiv skaliert werden, welche für Unternehmen so wertvoll sind.

Ich hoffe, die deutsche Übersetzung hilft Ihnen weiter. Sollten Sie noch Unterstützung beim Finalisieren oder Korrekturlesen benötigen, stehe ich gerne zur Verfügung. Bitte zögern Sie nicht, mich wissen zu lassen, wenn Sie noch weitere Abschnitte oder den gesamten Text übersetzt haben möchten!